AIとHPCの未来を支える最適解 NVIDIA Blackwell GPU対応

最高のパフォーマンスと効率性を実現する

Supermicroの液冷ソリューション

高密度AIデータセンターやHPC環境に最適化された液冷技術で、

環境負荷の軽減とコスト削減を両立!

よくある課題

サーバーの高密度化

AIやHPC(高性能計算)の需要増加に伴う計算資源の高密度化に対応できない。

サーバーの発熱量増加

高発熱により従来の空冷方式では対応が難しくなっている。

エネルギー消費の増大

エネルギー消費の増大によるコスト増加と環境負荷の懸念がある。

パフォーマンスと効率性を実現する

Supermicroの液冷ソリューション

最新技術を搭載

NVIDIA HGX B200 8-GPUシステムを採用し、トレーニング性能は前世代比で最大4倍、推論性能は30倍向上。

ラックスケールの効率性

革新的な垂直冷却液分配マニホールド(CDM)により、より多くの計算ノードを1ラック内に配置可能。

環境に優しい設計

直接液冷(DLC)技術により、データセンター全体の電力使用量を最大40%削減。

導入による効果

その1:パフォーマンスの向上

| 高密度レイアウト | 液冷技術により、ラックあたりのサーバーやGPUの搭載量を最大化できます。従来の空冷方式では実現が難しい高密度でのAI/HPCワークロードの処理が可能になります。 |

|---|---|

| 高発熱対応 | 液冷は空冷に比べて熱伝導効率が高いため、発熱量が多いGPUやCPUでも安定的に稼働できます。これにより、計算性能を最大限に引き出すことが可能です。 |

その2:コスト削減

| エネルギー効率の改善(PUE改善) | 液冷技術により、データセンター全体の電力消費を大幅に削減します。Power Usage Effectiveness(PUE)の値を改善することで、冷却コストを削減し、総所有コスト(TCO)を低減します。データセンター全体の電気代を最大40%削減し、サーバー冷却インフラの電気代を最大89%削減します。 |

|---|---|

| 短期ROI(投資回収期間)の実現 | 液冷ソリューションの導入により、運用コストを最大40%削減することができます。システムの規模や運用環境にもよりますが、初期投資を数年で回収することも可能です。これにより、急増するAI/HPC需要に柔軟に対応できます。 |

その3:環境負荷の軽減

| CO2排出量の削減 | エネルギー消費を削減することで、データセンターの二酸化炭素排出量を抑えます。サステナビリティへの取り組みを強化し、環境に配慮した運用が可能です。 |

|---|---|

| 水資源の効率的利用 | 大規模空冷システムで使用する冷却塔にくらべて、使用する水の量を減らし、蒸発や廃水処理の負担を軽減することができます。 |

その4:信頼性の向上

| 24時間365日稼働の確保 | 液冷技術は、発熱リスクを最小化し、データセンターの24時間365日の安定稼働を支援します。これにより、ビジネスの継続性が保証されます。 |

|---|---|

| 異常検知の強化 | SuperCloud Composerなどの管理ツールと組み合わせることで、リアルタイムの監視と異常検知が可能。障害の早期発見と対処により、ダウンタイムを最小限に抑えます。 |

全てが揃うから早い

単一ベンダーによる実証済みソリューション

Supermicroは、ハードウェアからソフトウェアまでのトータルラックスケール液冷ソリューションを提供。

サーバー、ラック、ネットワーク、液冷インフラストラクチャを含む実証されたソリューションを提供し、導入までの時間を短縮し、インフラストラクチャ全体の品質を向上させます。

冷却塔

ラック統合サービス

液冷サーバー

冷却コンポーネント

Supermicro液冷(水冷)ソリューションの導入を

正規代理店であるテックウインドがサポートします!

最新GPUアーキテクチャである

NVIDIA Blackwell GPUにも対応

AIの時代において、コンピュートユニットはもはやサーバーの数だけでは測れません。 相互接続されたGPU、 CPU、 メモリー、 ストレージ、そしてラック内の複数のノードにまたがるこれらのリソースが、今日の人工知能を構築しています。 このようなインフラストラクチャには、高速かつ低レイテンシーのネットワークファブリックと、各データセンター環境に最適なパフォーマンスと効率を維持するために緻密に設計された冷却技術と電力供給が必要です。SupermicroのSuperClusterソリューションは、NVIDIA Blackwellプラットフォームに最適化した熱設計、電力設計、ネットワーク設計を実現し、急速に進化する生成AIと大規模言語モデル(LLM)にエンドツーエンドのAIデータセンターソリューションを提供します。

ラック統合サービスのご紹介(一部)

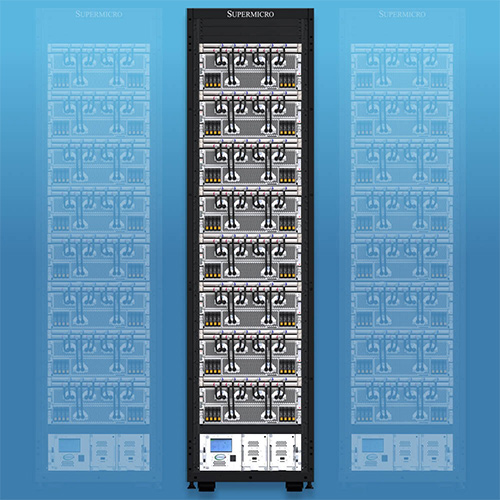

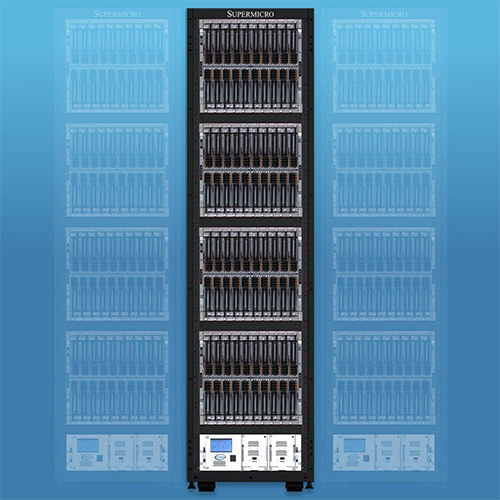

NVIDIA GB200 NVL72

1ラックで液冷エクサスケール・スーパーコンピューターを実現

- 72基のNVIDIA Blackwell GPUがHBM3eメモリーの巨大なプールを備えた1つのGPUとして動作

- 9個のNVIDIA® NVLink®スイッチが、コンピュートトレイあたり4ポートで72 GPUを接続し、1.8TB/秒のGPU間相互接続を実現

- 250kW容量In-Row冷却液分配ユニット(冗長PSUおよびデュアルホットスワップポンプ付き)、または240kW/180kW容量のLiquid-to-airソリューション(設備用水不要)

- エンドツーエンドの液冷ソリューションと包括的なオンサイト導入サービス

- NVIDIA BlueField®-3 SuperNIC、Spectrum™-X、Quantum-2、および次世代800Gb/秒ネットワーキングプラットフォームを含む高度なネットワーキングに対応

NVIDIA HGX B200搭載の液冷サーバー製品はこちら

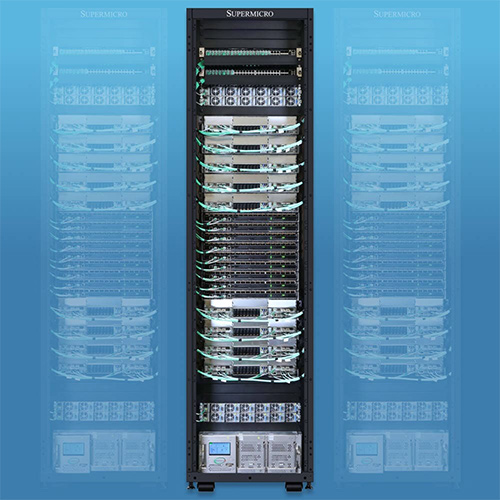

業界をリードする液冷AIクラスター

32台のNVIDIA HGX H100/H200 8-GPU、4U液冷システム(256 GPU)を5ラックに搭載

- カスタム液冷(水冷)ソリューションにより、 データセンターの電力コストを最大40%削減し、コンピューティング密度を倍増

- 256基のNVIDIA H100/H200 GPUを1つのスケーラブルなユニットに統合

- H100では20TBのHBM3、H200では36TB のHBM3eを1つのスケーラブルなユニットに統合

- 各GPUへの1:1ネットワークにより、NVIDIA GPUDirect® RDMAおよび最大数兆のパラメータを持つ大規模言語モデルのトレーニング用ストレージが可能

- 業界をリードする並列ファイルシステムオプションを備えたカスタマイズ可能なAlデータパイプラインストレージファブリック

- NVIDIA Quantum-2 InfiniBandおよび Spectrum™-X Ethernetプラットフォームをサポート

- NVIDIA NIM™マイクロサービスを含むNVIDIA AI Enterprise Platformの認定を取得

液冷ラックの実証された設計

AI/LLM ラック

NVIDIA GB200 NVL72

50Uラックに最大72基のNVIDIA Blackwell GPU 、18個のコンピュートノードを搭載

- 1U Liquid-cooled Server with 2x NVIDIA GB200 Grace Blackwell Superchips x 18

- 33kW Power Shelves x 8

- CDU x 1

- Vertical CDM x 2

- NVLink Switch x 9

- In-band & Out-of-band Management Switch x 1

GPU最適化サーバー

48Uラックに最新GPUを最大64基、GPUサーバー8台を搭載

- 4U 8-GPU Server with NVIDIA HGX™ H100/H200 or AMD Instinct™ MI300X/MI325X x 8

- CDU x 1

- Vertical CDM x 1

- Horizontal CDM x 8

- Switch x 2

- In-band & Out-of-band Management Switch x 1

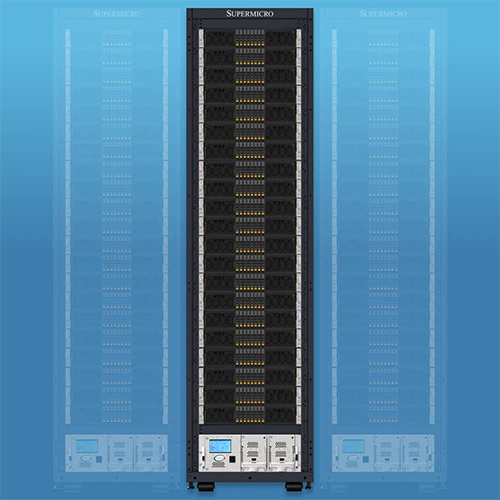

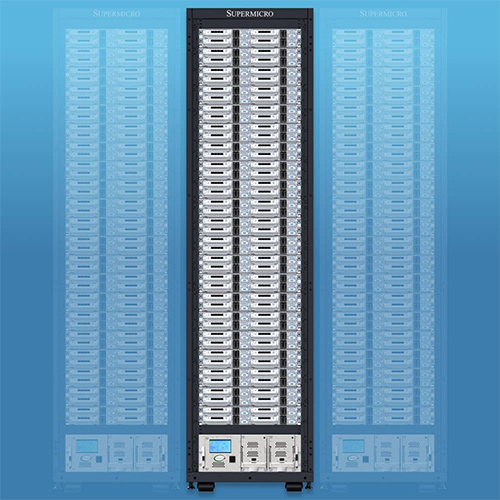

エンタープライズラック

業界をリードするマルチノードアーキテクチャ

48Uラックに76個のサーバーノード、19個のシステムを搭載

- BigTwin (2U4N) x 19

- CDU x 1

- Vertical CDM x 1

- Switch x 1

2Uフラッグシップラックマウントアーキテクチャ

48Uラックに21個のDPサーバーを搭載

- 2U Hyper x 21

- CDU x 1

- Vertical CDM x 1

- Switch x 1

1Uフラッグシップラックマウントアーキテクチャ

48Uラックに44個のサーバーを搭載

- 1U Hyper x 44

- CDU x 1

- Vertical CDM x 1

- Switch x 1

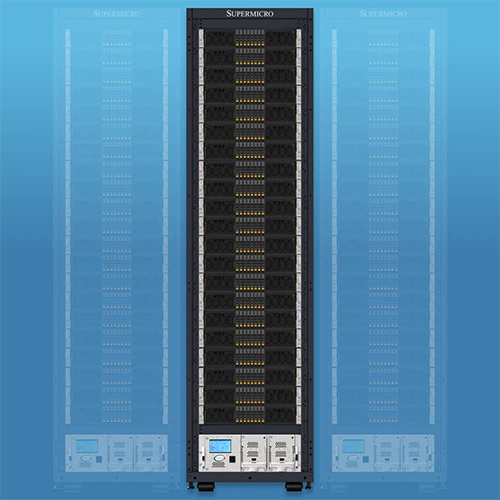

高密度HPCラック

目的別HPC大規模ソリューション

48Uラックに84個のサーバーノードと21個のシステムを搭載

- FlexTwin™ Server (2U4N) x 21

- CDU x 1

- Vertical CDM x 1

- Switch x 1

最大密度マルチノードアーキテクチャ

48Uラックに80個のサーバーブレードと4個のシステムを搭載

- SuperBlade Enclosure (8U20N) x 4

- DP SuperBlade® Sled x 80

- CDU x 1

- Vertical CDM x 1

- Horizontal CDM x 8

- Switch x 1

対応可能な液冷タイプ

ダイレクトチップ

In-Row CDU付きダイレクトチップ

リアドア熱交換器

| 種類 | PUE | ラック当たりの対応発熱量 |

|---|---|---|

| Liquid to Liquid(L2L) | 1.09 | 100kW+ |

| Liquid to Air(L2A) | 1.5 | 80kW |

複数のサーバー管理を効率化する

クラウド管理ツール

SupermicroのSuperCloud Composer(SCC)は、アジャイルでクラウドのような環境を構築し、 高度に自動化されたソフトウェア定義のコンポーザブルインフラストラクチャを提供することで、 効率的な運用と変化するビジネス要件への迅速な対応という2つの課題に対応します。

| 時間とコストの削減 | 自動化と統合管理により、運用コストを大幅に削減。 |

|---|---|

| 効率的なリソースの利用 | 余剰リソースの無駄をなくし、必要な場所に適切な計算資源を割り当て。 |

| スケーラビリティー | プロジェクトや利用者の増加に柔軟に対応。 |

Supermicro液冷(水冷)ソリューションの導入を

正規代理店であるテックウインドがサポートします!

Supermicroの実績と受賞歴

実績豊富なSupermicroだから安心

Supermicroは、NVIDIAと協力して、これまでに10万個のGPUを出荷しており、世界最大の液冷AIデータセンタープロジェクトを展開するための準備をしてきました。

日本でも、液冷ソリューションを大規模AIデータセンターやコンテナ型データセンターへ導入した実績があります。

Best Data Center Cooling Solution受賞

Supermicroは、2024年のComputex Best Choice Awardsで「Best Data Center Cooling Solution」を受賞しています。

この賞は、Supermicroの直接液冷(DLC)ラックソリューションとGPU AI/HPCサーバーに対して贈られたものです。

同社の液冷技術がデータセンターの冷却効率を向上させ、エネルギーコストを削減することに寄与していることを証明しています。

テックウインドは、Supermicroとタッグを組み、お客様の液冷ソリューション導入を最大限サポートさせていただきます。

導入の流れ

1. お問い合わせ

サービスの詳細を知りたい方、導入を検討中の方、お見積りをご希望の方は、お問い合わせフォームからお気軽にご相談ください。担当営業より2~3日営業日中にお返事いたします。

2. ヒアリングと仕様確認提案

ヒアリング後に、消費電力算出やラックレイアウト決定、使用部品の策定や設置場所の調査を行います。

3. 製造&調整

CDU、CDM、ホースなどのラック設置や調整、ケーブル配線やラベルの添付などを行います。

4. 試験&検証

動作試験や電力測定、ベンチマーク測定などを行います。

5. 配送&設置

梱包と出荷を行い、設置や設定など現地での調整を行います。

6. 保守サービス

出荷後のお客様へのトレーニングや故障した場合の対応を行います。

ビジネスに必要なIT機器の導入をサポートいたします